In diesem Artikel werden einige Möglichkeiten zum Crawlen einer Website erläutert, einschließlich Tools für das Web-Crawling und der Verwendung dieser Tools für verschiedene Funktionen. Die in diesem Artikel besprochenen Tools umfassen:

- HTTrack

- Cyotek WebCopy

- Content-Grabber

- ParseHub

- OutWit Hub

HTTrack

HTTrack ist eine kostenlose Open-Source-Software zum Herunterladen von Daten von Websites im Internet. Es ist eine einfach zu bedienende Software, die von Xavier Roche entwickelt wurde. Die heruntergeladenen Daten werden auf localhost in der gleichen Struktur wie auf der ursprünglichen Website gespeichert. Gehen Sie wie folgt vor, um dieses Dienstprogramm zu verwenden:

Installieren Sie zuerst HTTrack auf Ihrem Computer, indem Sie den folgenden Befehl ausführen:

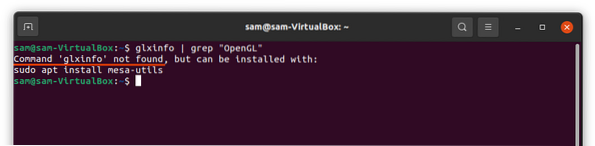

[email protected]:~$ sudo apt-get install httrackFühren Sie nach der Installation der Software den folgenden Befehl aus, um die Website zu crawlen. Im folgenden Beispiel werden wir crawlen linuxhint.com:

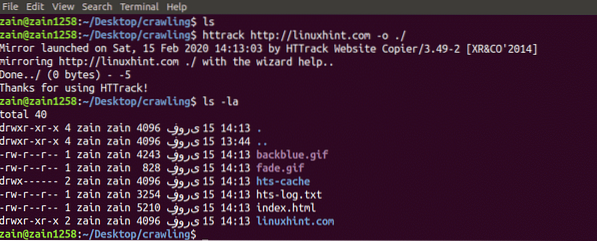

[email protected]:~$ httrack http://www.linuxhint.com -o ./Der obige Befehl holt alle Daten von der Site und speichert sie im aktuellen Verzeichnis. Das folgende Bild beschreibt die Verwendung von httrack:

Aus der Abbildung können wir sehen, dass die Daten von der Site abgerufen und im aktuellen Verzeichnis gespeichert wurden.

Cyotek WebCopy

Cyotek WebCopy ist eine kostenlose Web-Crawling-Software zum Kopieren von Inhalten von einer Website auf den localhost. Nach dem Ausführen des Programms und der Bereitstellung des Website-Links und des Zielordners wird die gesamte Website von der angegebenen URL kopiert und im localhost gespeichert. Herunterladen Cyotek WebCopy aus folgendem Link:

https://www.cyoteke.com/cyotek-webcopy/downloads

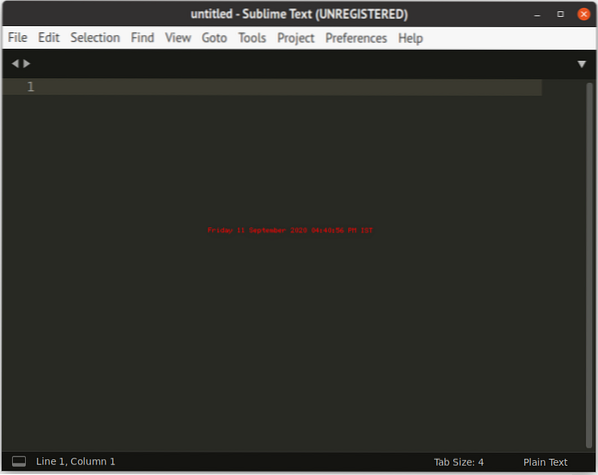

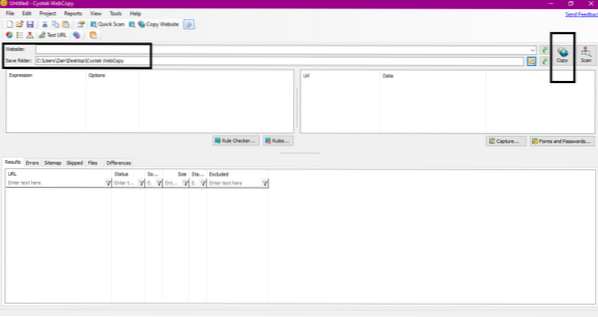

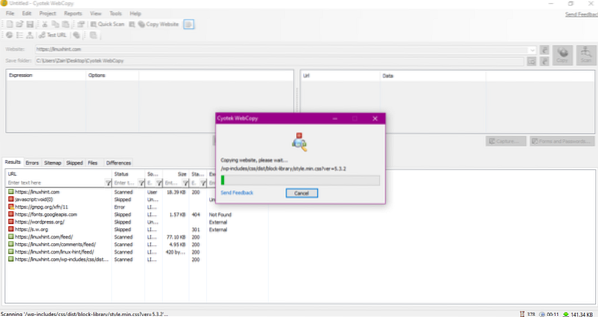

Nach der Installation wird beim Ausführen des Webcrawlers das unten abgebildete Fenster angezeigt:

Nachdem Sie die URL der Website eingegeben und den Zielordner in den erforderlichen Feldern festgelegt haben, klicken Sie auf Kopieren, um mit dem Kopieren der Daten von der Website zu beginnen, wie unten gezeigt:

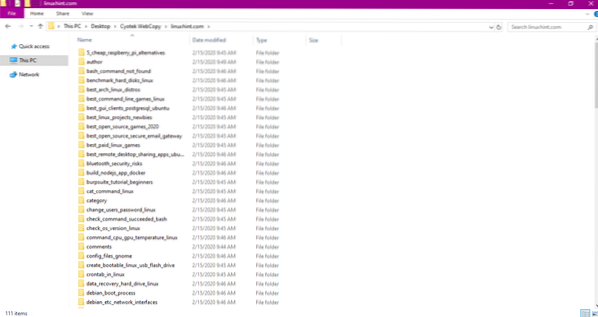

Überprüfen Sie nach dem Kopieren der Daten von der Website wie folgt, ob die Daten in das Zielverzeichnis kopiert wurden:

Im obigen Bild wurden alle Daten von der Site kopiert und am Zielort gespeichert saved.

Content-Grabber

Content Grabber ist ein Cloud-basiertes Softwareprogramm, das verwendet wird, um Daten von einer Website zu extrahieren. Es kann Daten von jeder Website mit mehreren Strukturen extrahieren. Sie können Content Grabber unter folgendem Link herunterladen

http://www.tucows.com/preview/1601497/Content-Grabber

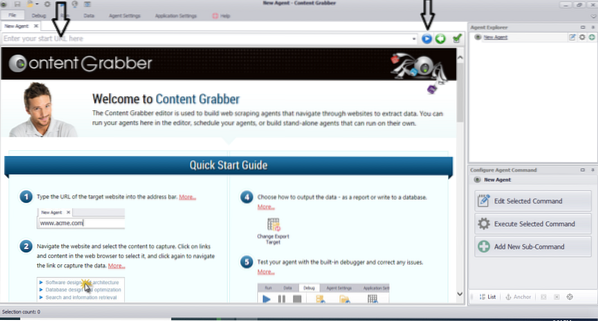

Nach der Installation und Ausführung des Programms erscheint ein Fenster, wie in der folgenden Abbildung dargestellt:

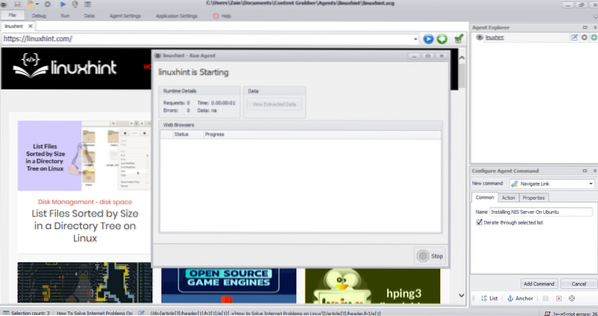

Geben Sie die URL der Website ein, von der Sie Daten extrahieren möchten. Nachdem Sie die URL der Website eingegeben haben, wählen Sie das Element aus, das Sie kopieren möchten, wie unten gezeigt:

Nachdem Sie das erforderliche Element ausgewählt haben, beginnen Sie mit dem Kopieren von Daten von der Site. Dies sollte wie im folgenden Bild aussehen:

Die von einer Website extrahierten Daten werden standardmäßig an folgendem Ort gespeichert:

C:\Benutzer\Benutzername\Dokument\Content GrabberParseHub

ParseHub ist ein kostenloses und benutzerfreundliches Web-Crawling-Tool. Dieses Programm kann Bilder, Texte und andere Formen von Daten von einer Website kopieren. Klicken Sie auf den folgenden Link, um ParseHub herunterzuladen:

https://www.Parsehub.com/Schnellstart

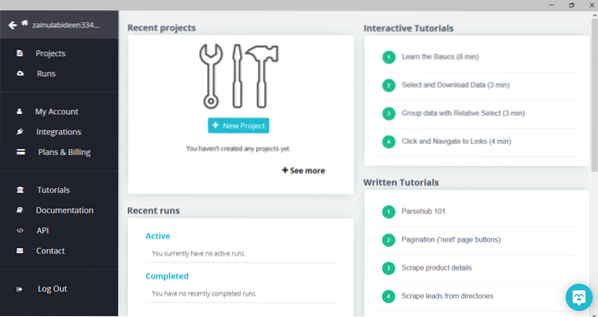

Führen Sie nach dem Herunterladen und Installieren von ParseHub das Programm aus. Ein Fenster wird angezeigt, wie unten gezeigt:

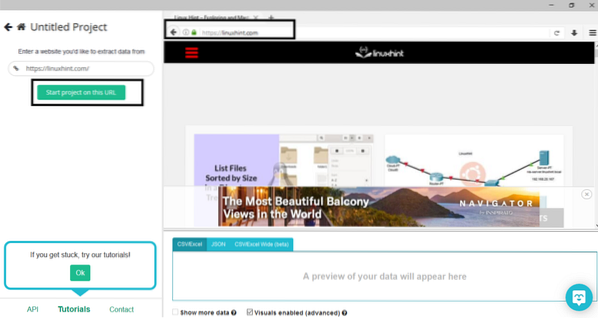

Klicken Sie auf „Neues Projekt“, geben Sie die URL in die Adressleiste der Website ein, von der Sie Daten extrahieren möchten, und drücken Sie die Eingabetaste. Klicken Sie anschließend auf „Projekt auf dieser URL starten“.”

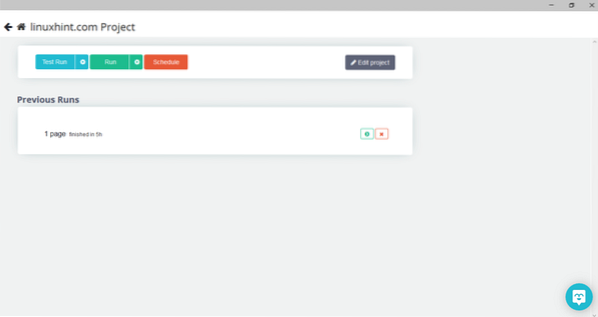

Nachdem Sie die gewünschte Seite ausgewählt haben, klicken Sie auf der linken Seite auf „Get Data“, um die Webseite zu crawlen. Es erscheint folgendes Fenster:

Klicken Sie auf „Ausführen“ und das Programm fragt nach dem Datentyp, den Sie herunterladen möchten. Wählen Sie den gewünschten Typ und das Programm fragt nach dem Zielordner. Speichern Sie abschließend die Daten im Zielverzeichnis.

OutWit Hub

OutWit Hub ist ein Webcrawler zum Extrahieren von Daten von Websites. Dieses Programm kann Bilder, Links, Kontakte, Daten und Text von einer Website extrahieren. Die einzigen erforderlichen Schritte sind die Eingabe der URL der Website und die Auswahl des zu extrahierenden Datentyps. Laden Sie diese Software über den folgenden Link herunter:

https://www.überlisten.de/produkte/hub/

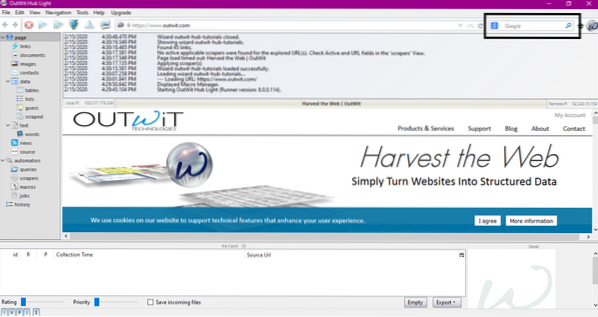

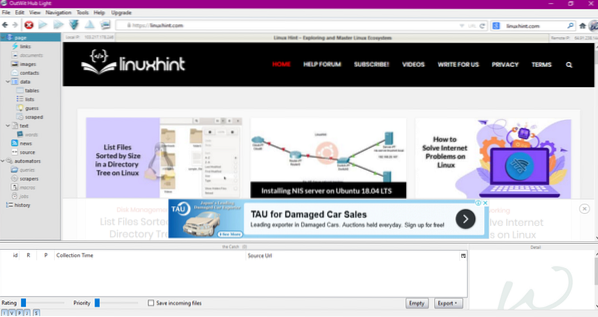

Nach der Installation und Ausführung des Programms erscheint folgendes Fenster:

Geben Sie die URL der Website in das im obigen Bild gezeigte Feld ein und drücken Sie die Eingabetaste. Das Fenster zeigt die Website wie unten gezeigt an:

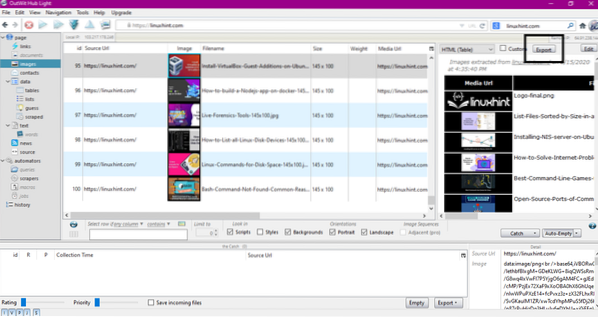

Wählen Sie im linken Bereich den Datentyp aus, den Sie von der Website extrahieren möchten. Das folgende Bild veranschaulicht diesen Vorgang genau:

Wählen Sie nun das Bild aus, das Sie auf dem localhost speichern möchten, und klicken Sie auf den im Bild markierten Export-Button. Das Programm fragt nach dem Zielverzeichnis und speichert die Daten im Verzeichnis.

Fazit

Webcrawler werden verwendet, um Daten von Websites zu extrahieren. In diesem Artikel wurden einige Web-Crawling-Tools und deren Verwendung beschrieben. Die Nutzung jedes Webcrawlers wurde Schritt für Schritt besprochen und ggf. mit Zahlen versehen. Ich hoffe, dass es Ihnen nach dem Lesen dieses Artikels leicht fällt, diese Tools zum Crawlen einer Website zu verwenden.

Phenquestions

Phenquestions