Big Data sind Daten in der Größenordnung von Terabyte oder Petabyte und darüber hinaus, bestehend aus Mining, Analyse und prädiktiver Modellierung großer Datensätze. Das schnelle Wachstum von Informationen und technologischen Entwicklungen hat Einzelpersonen und Unternehmen auf der ganzen Welt eine einzigartige Gelegenheit geboten, Gewinne zu erzielen und neue Fähigkeiten zu entwickeln, die traditionelle Geschäftsmodelle mit Hilfe von groß angelegten Analysen neu definieren.

Dieser Artikel bietet eine Vogelperspektive auf fünf der beliebtesten Open-Source-Datenplattformen. Hier ist unsere Liste:

Apache Hadoop

Apache Hadoop ist eine Open-Source-Softwareplattform, die sehr große Datensätze in einer verteilten Umgebung in Bezug auf Speicher und Rechenleistung verarbeitet und hauptsächlich auf kostengünstiger Standardhardware basiert.

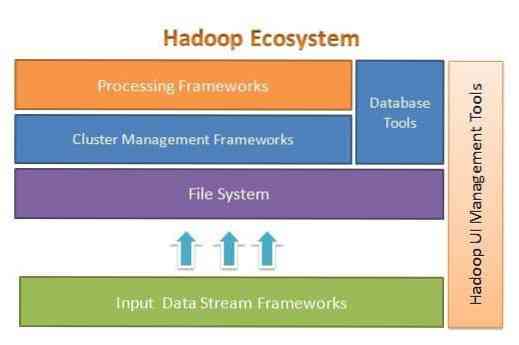

Apache Hadoop ist für die einfache Skalierung von wenigen auf Tausende von Servern ausgelegt. Es hilft Ihnen, lokal gespeicherte Daten in einem Gesamtparallelverarbeitungs-Setup zu verarbeiten. Einer der Vorteile von Hadoop besteht darin, dass Fehler auf Softwareebene behandelt werden. Die folgende Abbildung veranschaulicht die Gesamtarchitektur des Hadoop-Ökosystems und wo sich die verschiedenen Frameworks darin befinden:

Apache Hadoop bietet ein Framework für die Dateisystemschicht, die Clusterverwaltungsschicht und die Verarbeitungsschicht. Es bietet anderen Projekten und Frameworks die Möglichkeit, neben Hadoop Ecosystem zu arbeiten und ihr eigenes Framework für alle im System verfügbaren Schichten zu entwickeln.

Apache Hadoop besteht aus vier Hauptmodulen. Diese Module sind Hadoop Distributed File System (die Dateisystemschicht), Hadoop MapReduce (das sowohl mit der Clusterverwaltung als auch der Verarbeitungsschicht funktioniert), Yet Another Resource Negotiator (YARN, die Clusterverwaltungsschicht) und Hadoop Common.

Elasticsearch

Elasticsearch ist eine volltextbasierte Such- und Analysemaschine. Es ist ein hoch skalierbares und verteiltes System, das speziell für die effiziente und schnelle Arbeit mit Big-Data-Systemen entwickelt wurde, bei denen einer der Hauptanwendungsfälle die Protokollanalyse ist. Es ist in der Lage, fortgeschrittene und komplexe Suchen durchzuführen und fast in Echtzeit für erweiterte Analysen und operative Intelligenz zu verarbeiten.

Elasticsearch ist in Java geschrieben und basiert auf Apache Lucene. Im Jahr 2010 veröffentlicht und aufgrund seiner flexiblen Datenstruktur, skalierbaren Architektur und sehr schnellen Reaktionszeit schnell an Popularität gewonnen. Elasticsearch basiert auf einem JSON-Dokument mit einer schemafreien Struktur, was die Einführung einfach und problemlos macht. Es ist eine der Top-Ranking-Suchmaschinen der Enterprise-Klasse. Sie können seinen Client in jeder Programmiersprache schreiben; Elasticsearch arbeitet offiziell mit Java, .NET, PHP, Python, Perl usw.

Elasticsearch interagiert hauptsächlich über eine REST-API. Es erhält Daten in Form von JSON-Dokumenten mit allen erforderlichen Parametern und liefert seine Antwort auf ähnliche Weise.

MongoDB

MongoDB ist eine NoSQL-Datenbank basierend auf dem Dokumentenspeicher-Datenmodell. In MongoDB ist alles entweder Sammlung oder Dokument. Um die MongoDB-Terminologie zu verstehen, ist Sammlung ein alternatives Wort für Tabelle, während Dokument ein alternatives Wort für Zeilen ist.

MongoDB ist eine Open-Source-, dokumentenorientierte und plattformübergreifende Datenbank. Es ist hauptsächlich in C . geschrieben++. Es ist auch die führende NoSQL-Datenbank, die hohe Leistung, hohe Verfügbarkeit und einfache Skalierbarkeit bietet. MongoDB verwendet JSON-ähnliche Dokumente mit Schema und bietet eine umfassende Abfrageunterstützung. Zu den wichtigsten Funktionen gehören Indizierung, Replikation, Lastausgleich, Aggregation und Dateispeicherung.

Kassandra

Cassandra ist ein Open-Source-Apache-Projekt, das für die Verwaltung von NoSQL-Datenbanken entwickelt wurde. Cassandra-Zeilen sind in Tabellen organisiert und durch einen Schlüssel indiziert. Es verwendet eine nur anhängende, protokollbasierte Speicher-Engine. Die Daten in Cassandra werden auf mehrere masterlose Knoten verteilt, ohne Single Point of Failure. Es ist ein Apache-Projekt auf höchster Ebene, dessen Entwicklung derzeit von der Apache Software Foundation (ASF) überwacht wird.

Cassandra wurde entwickelt, um Probleme zu lösen, die mit dem Betrieb im großen (Web-) Maßstab verbunden sind. Aufgrund der masterlosen Architektur von Cassandra kann es trotz einer kleinen (wenn auch erheblichen) Anzahl von Hardwarefehlern weiterhin Operationen ausführen. Cassandra läuft über mehrere Knoten in mehreren Rechenzentren. Es repliziert Daten in diesen Rechenzentren, um Ausfälle oder Ausfallzeiten zu vermeiden. Dies macht es zu einem sehr fehlertoleranten System.

Cassandra verwendet seine eigene Programmiersprache, um auf Daten über seine Knoten hinweg zuzugreifen. Es heißt Cassandra Query Language oder CQL. Es ähnelt SQL, das hauptsächlich von relationalen Datenbanken verwendet wird. CQL kann verwendet werden, indem eine eigene Anwendung namens cqlsh ausgeführt wird. Cassandra bietet auch viele Integrationsschnittstellen für mehrere Programmiersprachen zum Erstellen einer Anwendung mit Cassandra. Seine Integrations-API unterstützt Java, C++, Python und andere.

Apache HBase

HBase ist ein weiteres Apache-Projekt zur Verwaltung des NoSQL-Datenspeichers. Es wurde entwickelt, um die Funktionen des Hadoop-Ökosystems zu nutzen, einschließlich Zuverlässigkeit, Fehlertoleranz usw. Es verwendet HDFS als Dateisystem für Speicherzwecke. Es gibt mehrere Datenmodelle, mit denen NoSQL arbeitet und Apache HBase gehört zum spaltenorientierten Datenmodell. HBase basierte ursprünglich auf Google Big Table, was auch mit dem spaltenorientierten Modell für unstrukturierte Daten verwandt ist.

HBase speichert alles in Form eines Schlüssel-Wert-Paares. Wichtig zu beachten ist, dass in HBase ein Schlüssel und ein Wert in Form von Bytes vorliegen. Um also Informationen in HBase zu speichern, müssen Sie Informationen in Bytes umwandeln. (Mit anderen Worten, seine API akzeptiert nichts anderes als ein Byte-Array.) Seien Sie vorsichtig mit HBase, denn wenn Sie Daten speichern, sollten Sie sich an den ursprünglichen Typ erinnern. Daten, die ursprünglich ein String waren, werden als Byte-Array zurückgegeben, wenn sie falsch abgerufen werden. Als Ergebnis erstellt es einen Fehler in Ihrer Anwendung und stürzt Ihre Anwendung ab.

Hoffe dir hat dieser Artikel gefallen. Wenn Sie datenintensive Anwendungen planen und entwerfen möchten, dann können Sie Anuj Kumars Architektur datenintensiver Anwendungen. Diese Buch ist Ihr Tor zum Aufbau intelligenter datenintensiver Systeme, indem die wichtigsten datenintensiven Architekturprinzipien, Muster und Techniken direkt in Ihre Anwendungsarchitektur integriert werden.

Phenquestions

Phenquestions